今回は、YouTubeにおける動画をとりまく状況をご紹介しつつ、有害コンテンツ排除のために利用されているAIの課題についてご紹介します。

誤BAN被害などに遭わないためにも、YouTubeの利用者として知っておくべき内容なので、ぜひ最後までご覧ください。

YouTubeには嫌がらせやヘイトスピーチが数多くアップロードされている

YouTubeといえば、あらゆるカテゴリの動画や音源などがアップロードされるプラットフォームですが、昨今では「嫌がらせ」や「ヘイトスピーチ」などの内容を伴うものが増えてきている現状をご存知でしょうか。

この章では、YouTubeの公式サイトが半年に一度の頻度で公表している透明性レポートにて、不適切動画の件数などを見ながら、YouTubeにおける課題を整理していきます。

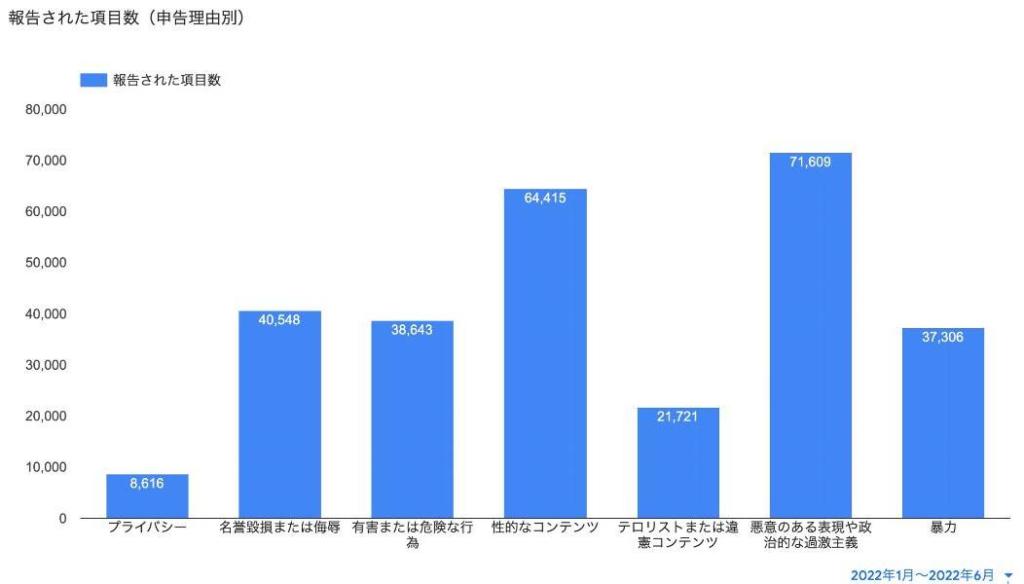

YouTubeに投稿された不適切動画の申告数と申し立て理由内訳(2022年1月~6月)

まずは、2022年1月~6月の間に報告されたYouTubeに投稿された不適切動画の申告数(申告理由別)についてです。

出典:Google透明性レポート(YouTube)不適切動画の申告数と申し立て理由内訳

上記のグラフは、2022年1月~6月の間に、YouTubeの不適切動画としてGoogle に報告された項目の数を、申し立ての理由別に示しています。

半年間合計で、282,858件もの動画がYouTubeに投稿された不適切動画として申し立てされていることがわかります。

つまり、1ヶ月あたり47,143件、1日あたり1,571件にも上ります。

中でも、「悪意のある表現や政治的な過激主義」についての申告件数が最も多く、次いで「性的なコンテンツ」の申告件数が多いことがわかります。

これだけの件数が日々報告され、その内容を1つずつ精査して、Googleの定めるガイドラインに違反していないかを確認していくのは、かなりの労力のかかる作業であろうことが推測されます。

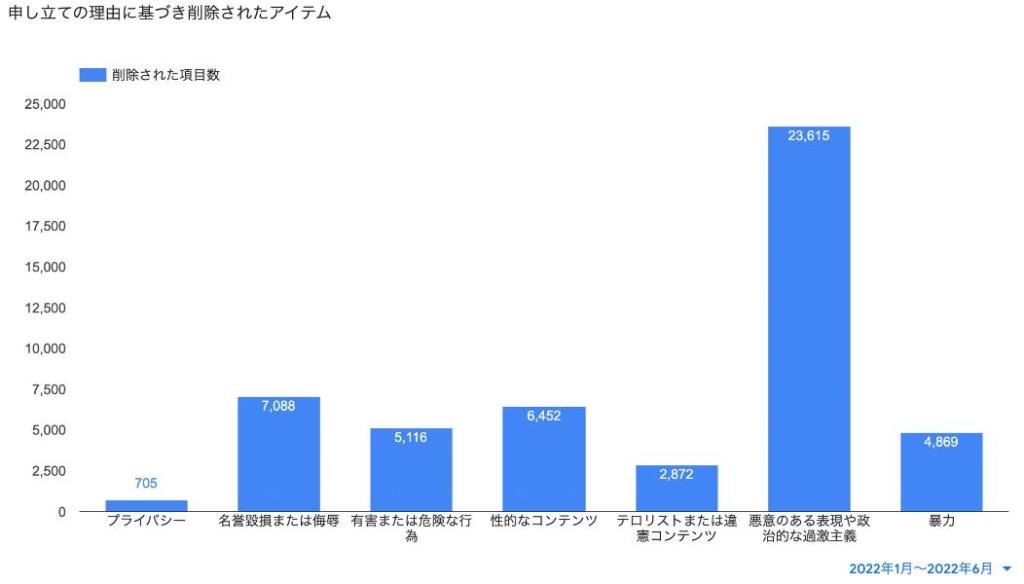

YouTubeに投稿された不適切動画の削除件数(2022年1月~6月)

次に、Googleに「YouTubeの不適切動画」として報告されたコンテンツのうち、ガイドライン違反が認められて実際に削除された件数をみていきます。

出典:Google透明性レポート(YouTube)不適切動画の削除件数

半年間合計で、不適切動画として申し立てされた内、50,717件の動画が不適切動画として削除されています。

不適切だと申告された動画の報告数282,858件に対して、約18%の動画が実際に削除されたことになります。

特に、「悪意のある表現や政治的な過激主義」については突出して削除件数が多く、このカテゴリだけで見ると約33%が削除対象となっていることがわかります。

このように、今回のテーマでもある「嫌がらせ」や「ヘイトスピーチ」が多くの不適切動画として報告され、実際に削除されているという現状をお分かりいただけたと思います。

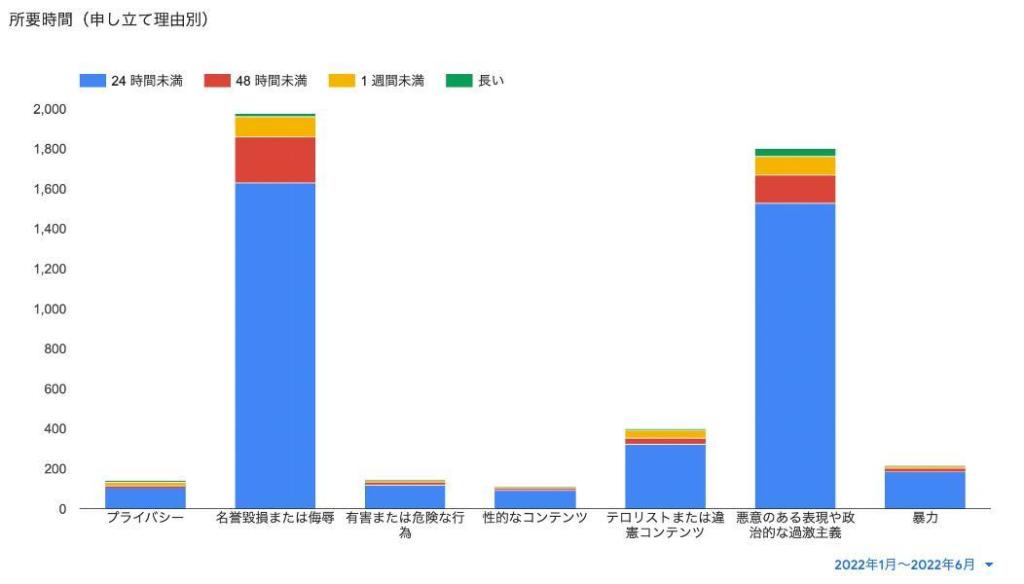

YouTubeに投稿された違法な不適切動画の削除までの所要時間(申し立て理由別)

次に、YouTubeに投稿された不適切動画の中で、「犯罪に該当し、違法と判断された項目」が、実際に削除されるまでの所要時間を見てみます。

出典:Google透明性レポート(YouTube)削除までの所要時間

全体傾向として、大半の動画が24時間未満に削除されていることがわかります。

ここまで見てきたように、大量の動画が日々不適切動画として報告され、1つ1つの動画をチェックしていることを考えると、非常にスピーディに処理がされていることがお分かりいただけると思います。

この背景には、「YouTubeの有害コンテンツ排除AI」の活躍があります。

YouTubeの有害コンテンツ削除におけるAIの活躍

YouTubeには大量の動画が日々アップロードされ、有害コンテンツとされて報告されてくる動画も数多くあることをみてきました。

大量の動画に対してガイドライン違反がないかを確認するために、人力だけでは追いつかないため、GoogleはAIを導入しています。

この章では、AIの導入により、どのような恩恵が受けられているのかについてご紹介します。

AIによりYouTubeに投稿された不適切動画の削除スピードは向上している

2017年の6月に、Googleはテロリズムや過激な動画をプラットフォーム上から排除するために、AIに注力することが公式の技術ブログにて発表されています。

出典:オンラインでテロと戦うために私たちが今日取っている 4 つのステップ

その半年後である2018年1月〜6月と、直近(2022年1月〜6月)の動画削除にかかる所要時間(申し立て理由別)を見てみたいと思います。

<2018年1月〜6月にYouTubeに投稿された違法な不適切動画の削除までの時間>

| 理由 | 24時間未満 | 48時間未満 | 1週間未満 | それ以上 |

|---|---|---|---|---|

| プライバシー | 2,794 | 774 | 659 | 446 |

| 名誉毀損または侮辱 | 11,046 | 112 | 176 | 94 |

| 有害または危険な行為 | 2,496 | 58 | 152 | 59 |

| 性的なコンテンツ | 7,042 | 62 | 180 | 54 |

| テロリストまたは違憲コンテンツ | 3,131 | 52 | 112 | 30 |

| 悪意のある表現や政治的な過激主義 | 23,956 | 285 | 447 | 116 |

| 暴力 | 3,734 | 60 | 110 | 60 |

| 合計 | 51,721 | 1,403 | 1,836 | 859 |

<2022年1月〜6月にYouTubeに投稿された違法な不適切動画の削除までの時間>

| 理由 | 24時間未満 | 48時間未満 | 1週間未満 | それ以上 |

|---|---|---|---|---|

| プライバシー | 104 | 11 | 16 | 9 |

| 名誉毀損または侮辱 | 1,630 | 227 | 105 | 17 |

| 有害または危険な行為 | 121 | 13 | 7 | 3 |

| 性的なコンテンツ | 94 | 9 | 5 | 2 |

| テロリストまたは違憲コンテンツ | 323 | 30 | 39 | 8 |

| 悪意のある表現や政治的な過激主義 | 1,528 | 142 | 90 | 40 |

| 暴力 | 186 | 19 | 8 | 0 |

| 合計 | 3,986 | 451 | 270 | 79 |

上記の表を見ていただくとわかる通り、違法な不適切動画の削除件数が直近の方が圧倒的に少なくなっています。

GoogleがYouTubeに導入している最新鋭のAIは、画像認識技術により、不適切動画として削除されたコンテンツと類似する動画は不適切動画の可能性が高いものとして、アップロード時点でのチェックも含め、報告される前に自動で削除されるようになっています。

そのため、不適切動画の報告件数自体は、YouTube全体の動画投稿数が増加すると共に増えているものの、「違法な不適切動画の削除件数」は、数年前と比べると圧倒的に減っており、プラットフォーム全体の健全化が進んでいるとも言えます。

AIは、24時間365日、安定した稼働を続けられるため、YouTubeにとってAIの導入は必須な状況になっています。

AIによる有害コンテンツ排除の問題点

上記では、YouTubeにおける有害コンテンツの排除に対するAIの有用性について解説してきました。

膨大な動画数を誇るYouTubeにとって、AIの活用は必須の状況ではあります。しかし、必ずしもメリットばかりではありません。

この章では、AIを導入した結果、発生している問題点について解説します。

AIの誤判定による動画削除が問題となっている

まずはAIの誤判定によって、削除されるべきではない動画まで削除されてしまっている点についてです。

これには2つの原因があります。

①行き過ぎた検閲による排除

YouTubeに動画をアップロードして収益を受けるためには、YouTubeパートナープログラム(YPP)に加入する必要があります。

このYPPには様々なポリシーがあり、このポリシーを遵守することが加入条件の1つになっていますが、YouTubeは、2019年12月11日に「嫌がらせやネットいじめに関するポリシー」を更新しました。

ポリシーの改訂内容のうちの1つとして、削除対処とする動画のタイプが拡大されています。

従来、YouTubeは、「おまえを殺してやる」というような直接的な脅ししか削除対象となりませんでしたが、潜在的だったり暗示的だったりする脅しも削除するように変更されています。

直接的な表現を避けて、ポリシーを回避しようとする悪質な動画が増えてきたことによる措置であるものと考えられます。

出典:YouTube|ハラスメントやネットいじめに関するポリシー

これに合わせて、YouTubeパートナープログラム(YPP)のポリシーも強化され、嫌がらせを繰り返すチャンネルはYPPから除外されるようになりました。

これにより悪質なユーザーがYouTubeで収益を上げられなくなり、最終的にはチャンネルごと消されることになります。

一方で、ブラックジョークや人によってはユーモアとして受け取られる内容についても、機械的な切り分けの結果、嫌がらせとして削除対象となってしまうケースも増加しています。

このままでは、誰か1人でも傷つく可能性のある動画は一切アップロードできず、動画の多様性やコンテンツの魅力が損なわれる可能性が危惧されています。

②画像の誤判定による削除

上記でも少し触れましたが、AIでは、アップロードされた動画に対して、過去の不適切動画とされるコンテンツとの類似点がないかどうかを確認するために画像判定技術を用いています。

その結果、ガイドライン違反ではない内容であるにも関わらず、色や輪郭が不適切なものであるとして動画が削除されたり、ライブ配信が停止される状況も発生しています。

たとえば、砂漠が裸体として判定されたり、赤いものが血液として判定されるなど、人の目によるチェックであれば問題ないものが、AIではセンシティブな動画であると誤認定されることがあります。

また、きちんと成人していても見た目が若い為、未成年と判断され、「未成年に対する厳しいポリシー」が誤って適応されてしまい、動画の削除対象となってしまう事例もあります。

YouTubeのAIの誤判定を悪用した迷惑行為が増加してきている

最近では、YouTubeのAIの自動判定機能を悪用した、迷惑行為も増加してきています。

具体的な事例としては、YouTubeのライブ配信におけるコメント機能で、卑猥なアイコンを使ったアカウントで卑猥なコメントがリアルタイムに連投されることで、AIにアダルトな配信であると誤認させ、配信者のチャンネルがBANされるというものです。

最近は、歌い手やVTuberなどによるライブ配信も増加しており、深刻な問題となっています。

誤判定が排除できない以上、人手をなくすことはできない

ここまで見てきたように、YouTubeにおける有害コンテンツの排除に対して、AIは重要な役割をになっている一方で、誤判定のリスクが顕在化しているという問題点があります。

誤判定をなくすために、AIの技術的な改善はされていくことが想定されますが、それでも100%正確な判定をすることは機械である以上、困難だと思われます。

結果的に、AIで一次切り分けを行い、ダブルチェックとしての人手をなくすことはできないでしょう。

まとめ

今回は、YouTubeにおける不適切動画に対するAIを活用したチェックの方法や、不適切動画の対象件数の推移からの分析、そして、AI導入により発生している問題点について解説しました。

YouTubeで動画を配信している方、YouTubeでの収益化を目指している方は、必ず知っておくべき事項なので、ぜひこの記事を参考に、AIによる誤判定のリスクについて認識していただければと思います。

コメント